È necessario perseguire un utilizzo sicuro e responsabile dell’AI nel campo della protezione dei dati personali.

Lo sviluppo dell’intelligenza artificiale crea interesse ma anche inquietudine negli operatori del campo della protezione dei dati. L’etica dovrebbe governarne l’impiego, ma le imprese perseguono il profitto, dunque servono regole chiare e applicabili, nonché controlli efficaci.

È ciò che emerge dal sondaggio Federprivacy condotto su 803 addetti ai lavori. Il 78,3% dei partecipanti concorda sulla necessità di trovare un equilibrio tra rispetto della privacy degli individui e apertura all’innovazione, mentre il 73,9% ritiene che gli attuali profili sanzionatori siano adeguati, ma occorre farli rispettare. Solo il 4,1% ritiene che si debba aumentare l’entità delle sanzioni, e il 21,6% pensa che si debbano adottare misure punitive diverse, tra cui provvedimenti penali.

Il punto sull’impatto della normativa

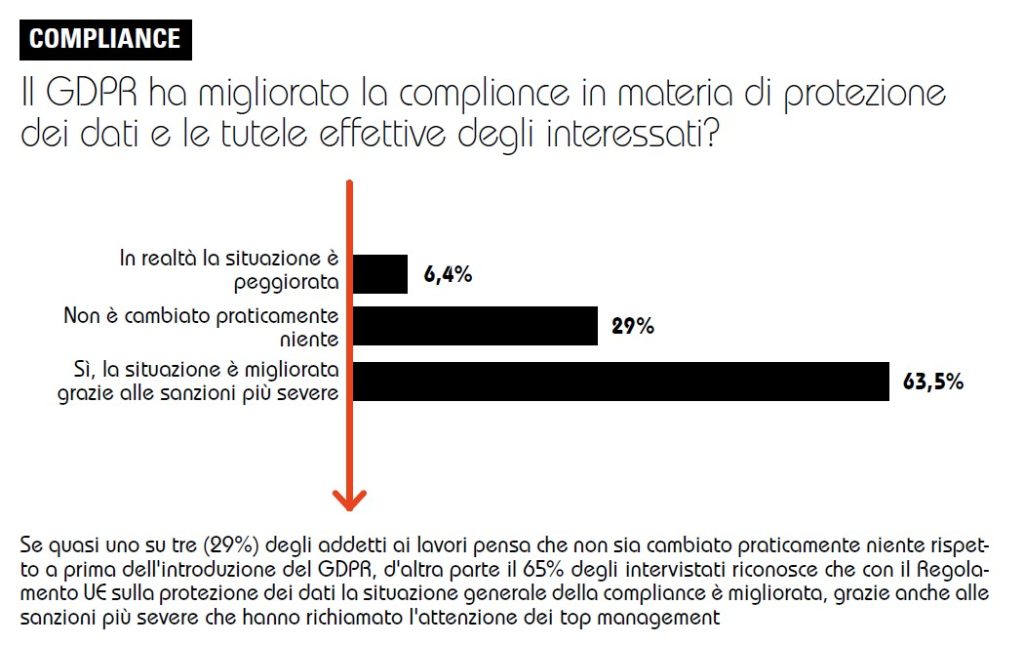

Il Gdpr, secondo il 29% dei rispondenti, non ha cambiato le cose, mentre il 63,5% afferma che la situazione generale della compliance è migliorata, anche grazie alle sanzioni più severe. Come emerge dall’indagine, l’aspetto negativo di questo regolamento è la scarsa attenzione alle Pmi e microimprese (56,9%), anche se per il 32,6% degli operatori il suo pregio consiste proprio nell’aver definito regole uguali per tutti.

Il parere sui numerosi regolamenti emanati dall’Unione Europea è controverso: Digital Services Act (DSA), Data Governance Act (DGA), Data Act (DA), Artificial Intelligence Act (AI Act), Digital Market Act (DMA), Cyber Resilience Act (CRA) per il 6,4% degli addetti ai lavori sono una complicazione aggiuntiva e non promuoveranno la compliance (27%), ma c’è un 40,2% di risposte che invece esprime fiducia nella possibilità che questo succeda.

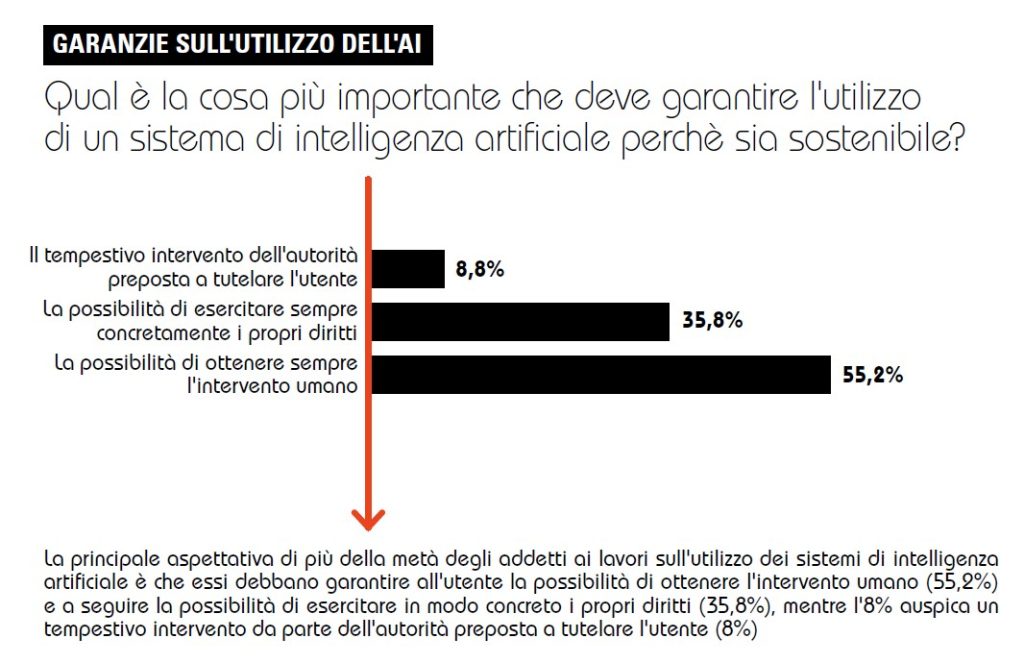

Rispetto alla AI, ciò che secondo il 55,2% dei rispondenti ne garantirebbe la sostenibilità, è la possibilità per gli utenti di ottenere l’intervento umano. Il 35,8% mette in cima alle priorità la garanzia concreta dei diritti delle persone, e l’8,8% il tempestivo intervento delle autorità di tutela.

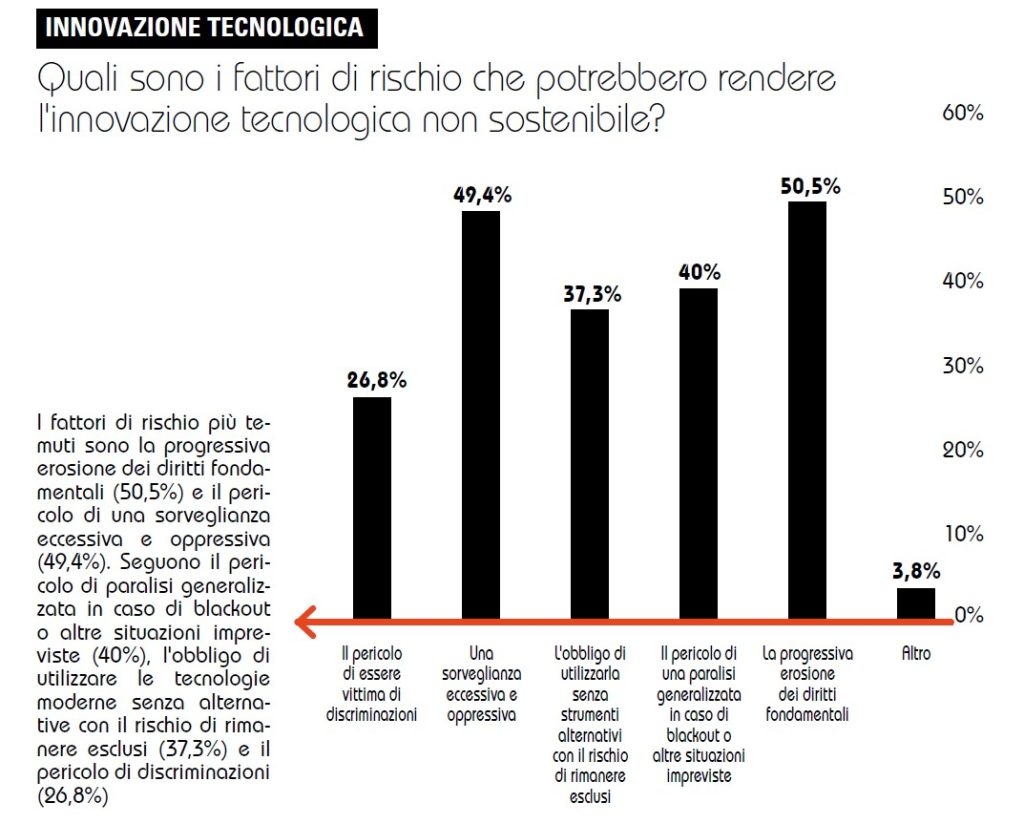

I rischi sono l’erosione dei diritti fondamentali (50,5%), la sorveglianza eccessiva (49,4%), la paralisi generalizzata in caso di blackout (40%), l’obbligo di usare l'AI senza alternative, con il rischio di rimanere esclusi (37,3%) o di discriminazioni (26,8%).

In cerca di etica e garanzie

Come favorire la sostenibilità tecnologica? Prima di tutto mettendo l’uomo al centro (70,1%), in maniera etica. Poi promuovendo l’educazione digitale (66,6%), l’uso etico dell'AI (63%) e garantendo l’inclusione (30,1%).

La strategia più efficace per ottenere più legalità è quella che punta su codici di condotta, certificazioni e modelli di privacy by design (66,3%), e sull’aumento delle attività ispettive del Garante per la protezione dei dati personali (43,2%). Importante anche la cooperazione con autorità estere (33,1%).

A conclusione del sondaggio, il 71,8% dei partecipanti pensa che la AI porti certamente opportunità, ma altrettanti grattacapi.